El software de IA pudo lograr puntajes de aprobación para el examen, que generalmente requiere años de capacitación médica.

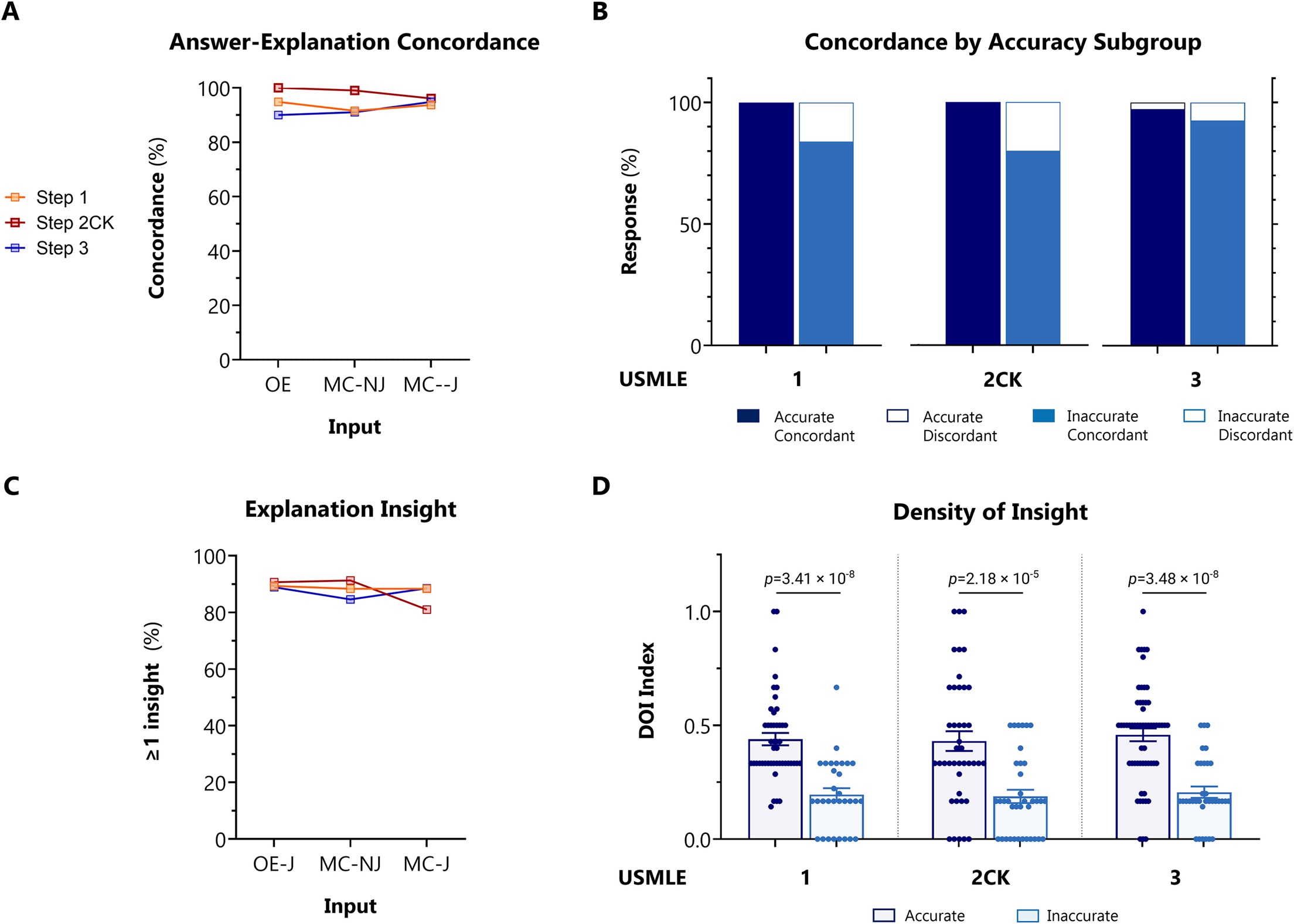

Concordancia y conocimiento de ChatGPT en USMLE. Para los pasos 1, 2CK y 3 del USMLE, los resultados de la IA se adjudicaron según la concordancia y la densidad de conocimiento (DOI) en función del sistema de puntuación ACI proporcionado en S2 Data. R: Concordancia general en todos los tipos de exámenes y formatos de codificación de preguntas. B: Tasas de concordancia estratificadas entre resultados precisos e inexactos, en todos los tipos de exámenes y formatos de codificación de preguntas. p <0,001 para resultados precisos frente a imprecisos mediante la prueba exacta de Fisher. C: prevalencia general de conocimiento, definida como la proporción de resultados con ≥1 conocimiento, en todos los exámenes para preguntas codificadas en formato MC-J. D: DOI estratificado entre resultados precisos e inexactos, en todos los tipos de exámenes para preguntas codificadas en formato MC-J. La línea horizontal indica la media. Valor de p determinado por prueba ANOVA paramétrica de 2 vías con Benjamini-Krieger-Yekutieli (BKY) post hoc para controlar la tasa de descubrimiento falso.

Comentarios

ChatGPT puede calificar en o alrededor del 60 por ciento del umbral de aprobación del Examen de Licencias Médicas de los Estados Unidos (USMLE), con respuestas que tienen un sentido interno coherente y contienen información frecuente, según un estudio publicado el 9 de febrero de 2023 en acceso abierto. revista PLOS Digital Health por Tiffany Kung, Victor Tseng y colegas de AnsibleHealth.

ChatGPT es un nuevo sistema de inteligencia artificial (IA), conocido como modelo de lenguaje grande (LLM), diseñado para generar una escritura similar a la humana mediante la predicción de secuencias de palabras próximas. A diferencia de la mayoría de los chatbots, ChatGPT no puede buscar en Internet. En su lugar, genera texto usando relaciones de palabras predichas por sus procesos internos.

Kung y sus colegas probaron el desempeño de ChatGPT en el USMLE, una serie de tres exámenes altamente estandarizados y regulados (Pasos 1, 2CK y 3) necesarios para obtener la licencia médica en los Estados Unidos. Tomado por estudiantes de medicina y médicos en formación, el USMLE evalúa el conocimiento que abarca la mayoría de las disciplinas médicas, desde la bioquímica hasta el razonamiento diagnóstico y la bioética.

Después de evaluar para eliminar las preguntas basadas en imágenes, los autores probaron el software en 350 de las 376 preguntas públicas disponibles desde el lanzamiento del USMLE de junio de 2022.

Después de eliminar las respuestas indeterminadas, ChatGPT obtuvo una puntuación de entre 52,4 % y 75,0 % en los tres exámenes USMLE. El umbral de aprobación cada año es de aproximadamente el 60%. ChatGPT también demostró una concordancia del 94,6 % en todas sus respuestas y produjo al menos una idea significativa (algo que era nuevo, no obvio y clínicamente válido) para el 88,9 % de sus respuestas. En particular, ChatGPT superó el rendimiento de PubMedGPT, un modelo homólogo formado exclusivamente en la literatura de dominio biomédico, que obtuvo una puntuación del 50,8 % en un conjunto de datos más antiguo de preguntas de estilo USMLE.

Si bien el tamaño de entrada relativamente pequeño restringió la profundidad y el rango de los análisis, los autores señalan que sus hallazgos brindan una idea del potencial de ChatGPT para mejorar la educación médica y, eventualmente, la práctica clínica. Por ejemplo, agregan, los médicos de AnsibleHealth ya usan ChatGPT para reescribir informes llenos de jerga para facilitar la comprensión del paciente.

“Alcanzar la puntuación de aprobación para este examen experto notoriamente difícil, y hacerlo sin ningún refuerzo humano, marca un hito notable en la maduración clínica de la IA”, dicen los autores.

La autora, la Dra. Tiffany Kung, agregó que el papel de ChatGPT en esta investigación fue más allá de ser el sujeto del estudio: "ChatGPT contribuyó sustancialmente a la redacción de [nuestro] manuscrito... Interactuamos con ChatGPT como un colega, pidiéndole que sintetice, simplifique y ofrecer contrapuntos a los borradores en curso... Todos los coautores valoraron la contribución de ChatGPT".

Discusión

En este estudio, brindamos evidencia nueva y sorprendente de que ChatGPT puede realizar varias tareas complejas relevantes para el manejo de información médica y clínica. Para evaluar las capacidades de ChatGPT frente a preguntas biomédicas y clínicas de complejidad y dificultad estandarizadas, probamos sus características de rendimiento en el Examen de Licencias Médicas de los Estados Unidos (USMLE).

Nuestros hallazgos se pueden organizar en dos temas principales: (1) la creciente precisión de ChatGPT, que se acerca o supera el umbral de aprobación de USMLE; y (2) el potencial de esta IA para generar conocimientos novedosos que pueden ayudar a los estudiantes humanos en un entorno de educación médica.

Más allá de su utilidad para la educación médica, las IA ahora están posicionadas para convertirse pronto en omnipresentes en la práctica clínica, con diversas aplicaciones en todos los sectores de atención médica. La investigación de la IA ahora ha entrado en la era de los ensayos controlados aleatorios. Además, una profusión de estudios pragmáticos y observacionales respalda el papel versátil de la IA en prácticamente todas las disciplinas y especialidades médicas al mejorar la evaluación de riesgos, la reducción de datos, el apoyo a las decisiones clínicas, la eficiencia operativa y la comunicación con el paciente.

Inspirados por el notable rendimiento de ChatGPT en el USMLE, los médicos de AnsibleHealth, una clínica virtual de enfermedades pulmonares crónicas, han comenzado a experimentar con ChatGPT como parte de sus flujos de trabajo. Al ingresar consultas de manera segura y sin identificación, nuestros médicos solicitan a ChatGPT que los ayude con las tareas de escritura tradicionalmente onerosas, como redactar cartas de apelación a los pagadores, simplificar los informes de radiología (y otros registros llenos de jerga) para facilitar la comprensión del paciente e incluso generar ideas y encender la percepción cuando se enfrenta a casos confusos y desafiantes desde el punto de vista del diagnóstico. Creemos que los LLM como ChatGPT están alcanzando un nivel de madurez que pronto tendrá un impacto en la medicina clínica en general, mejorando la prestación de atención médica individualizada, compasiva y escalable.

Fuente: https://www.intramed.net/

No hay comentarios:

Publicar un comentario

Nota: solo los miembros de este blog pueden publicar comentarios.